¡Cuidado con el ChatGPT! La Inteligencia Artificial (IA) se ha convertido en una herramienta cotidiana para millones de personas, brindando asistencia en tareas diversas, desde escribir correos hasta planear dietas.

Sin embargo, no todo lo que dice debe tomarse como una verdad absoluta. Un caso reciente y alarmante lo demuestra: un hombre de 60 años terminó hospitalizado tras seguir una recomendación errónea de ChatGPT.

Hombre se confió del ChatGPT

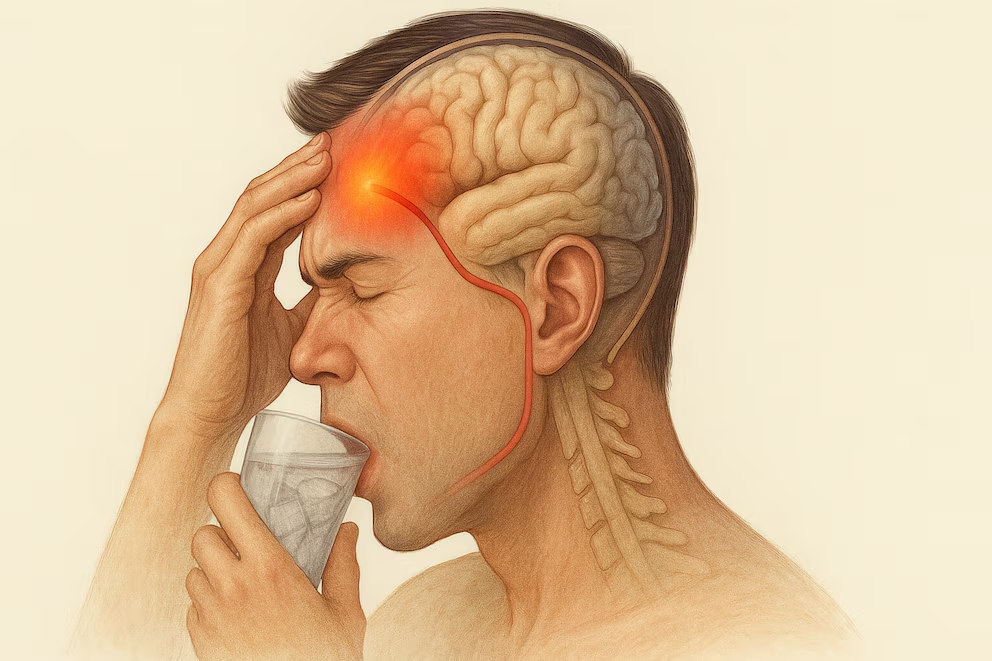

El caso, documentado en la revista Annals of Internal Medicine: Clinical Case, detalla cómo el paciente ingresó a urgencias presentando síntomas neurológicos y psiquiátricos, incluyendo paranoia, alucinaciones visuales y auditivas.

TAL VEZ TE INTERESE: Creador de ChatGPT, advierte que la IA hará desaparecer clases enteras de empleos

Inicialmente, creyó que su vecino intentaba envenenarlo, lo cual alertó al personal médico sobre una posible alteración mental. Tras varios días de evaluación, el paciente confesó que había reemplazado la sal común por bromuro de sodio, producto que le fue recomendado por la IA al buscar una alternativa alimenticia.

Una intoxicación del pasado que resurge por error de IA

El hombre había consumido bromuro de sodio durante tres meses, lo que provocó una acumulación peligrosa de esta sustancia en su cuerpo.

Fue diagnosticado con bromismo, una intoxicación poco común en la actualidad, pero que fue frecuente a inicios del siglo XX cuando se usaban sales de bromuro en medicamentos para tratar ansiedad e insomnio. El uso de estos compuestos fue prohibido por la FDA entre 1975 y 1989 debido a sus riesgos para la salud.

El tratamiento para desintoxicar al paciente incluyó diuresis salina y reposición de nutrientes. Afortunadamente, tras tres semanas de atención médica logró recuperarse por completo.

La importancia de verificar la información médica

Los síntomas del bromismo incluyen confusión, paranoia, problemas de coordinación, alteraciones en la piel y alucinaciones. Ante cualquiera de estas señales, es fundamental acudir a un médico y no depender de recomendaciones no verificadas, incluso si provienen de herramientas avanzadas como la Inteligencia Artificial.

Este caso subraya un mensaje clave: la IA es una herramienta de apoyo, no una fuente definitiva de consejos médicos. Las recomendaciones de salud deben ser siempre validadas por profesionales.

Consultar a un médico sigue siendo esencial para evitar consecuencias graves como las que vivió este hombre. No todo lo que sugiere la IA es correcto, y saber cuestionar sus respuestas puede salvar vidas.

TAL VEZ TE INTERESE: ¿ChatGPT te hace menos inteligente? Un estudio compara cerebros que usan IA y los que no